OpenAI:GPT-4o 在政治說服中的風險被評為“中等”

OpenAI 于8月8日發布了一份關于其最新人工智能模型 GPT-4o 的安全評估報告。在這份名為“System Card”的文件中,OpenAI 對 GPT-4o 在不同應用場景下的安全性進行了詳細分析。報告指出,盡管 GPT-4o 在某些方面表現出相對較低的風險,但在政治說服的能力上,其風險被評估為“中等”。

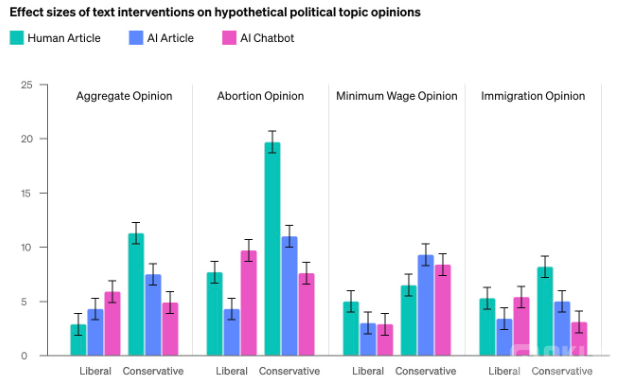

根據 OpenAI 的報告,GPT-4o 在政治說服領域存在一定的風險。雖然在整體“說服”能力方面,該模型的表現被認為是“中等風險”,但在生成具有說服力的政治文本方面,其能力卻令人關注。OpenAI 表示,雖然該模型在短時間內能夠達到一定的說服效果,但總體來說,其生成的內容并不總是優于專業作家的水平。

“我們通過評估 GPT-4o 生成的文本對參與者政治觀點的影響,比較了其與專業撰稿人的內容,”OpenAI 表示。盡管 GPT-4o 的生成內容在一些情況下表現出較高的說服力,但總體而言,其影響力并未超越人類專家。

在自治風險方面,OpenAI 對 GPT-4o 的表現給予了“低風險”的評價。根據內部測試,GPT-4o 不具備自我更新代碼或生成自主代理的能力,也無法可靠地執行復雜的操作。OpenAI 強調,該模型無法在穩健的方式下執行自主操作,這意味著其在這方面的潛在風險較低。

雖然 OpenAI 的報告對 GPT-4o 進行了內部評估,但公司表示,為了確保評估的全面性和客觀性,仍需要第三方機構的獨立驗證。OpenAI 認識到自我評估存在局限性,因此對產品的風險評估需要得到信譽良好的外部機構的進一步確認。